Идите в БАНю! Как Facebook на самом деле удаляет контент и блокирует пользователей

Казалось бы, модерация социальной сети с 2-миллиардным "населением" должна быть сложным процессом, в который вовлечена целая армия специалистов. Однако на самом деле ситуация обстоит иначе. Кто и почему принимает решения об удалении контента на Facebook и блокировании пользователей, рассказывает Фокус

"Мы удалили вашу публикацию за нарушение норм сообщества". Такое сообщение от Facebook хоть раз получали почти все пользователи, которые публикуют в соцсети не только фотографии котиков. Неосторожно высказавшись по наболевшему вопросу, можно получить бан на месяц, а в случае нескольких "рецидивов" – навсегда.

В группе риска находятся политики, а также политические журналисты и блогеры. За последнее время "в бане" успели побывать и блогер Анатолий Шарий, поспешивший обвинить в этом проукраинских сотрудников Facebook, глава Национального корпуса Андрей Билецкий, художник Андрей Ярмоленко, прославившийся альтернативными плакатами на тему российского Чемпионата мира по футболу-2018, и многие другие. Переживали подобный опыт и журналисты "Фокуса".

Забаненные лидеры мнений, как правило, обвиняют во всем ботофермы своих идеологических противников, которые могут забрасывать администрацию Facebook сотнями жалоб. Доля правды в этом есть – известно, что для удаления контента необходим "донос". Но почему в одних случаях хватает одного-единственного сигнала, а в других – добиться удаления контента не удается и после жалоб от сотен пользователей?

Компания утверждает, что решение принимается в зависимости от наличия в публикации "языка вражды", призывов к насилию или сексуализированного содержания. Но внутренние документы Facebook, попавшие в распоряжение журналистов The New York Times, доказывают – все гораздо сложнее.

Непросто, как банан

Возьмем хотя бы эмодзи. На первый взгляд это всего лишь безобидное украшение публикаций и сообщений. Так думают украинские пользователи, а также СММ-щики онлайн-магазинов и даже государственных структур, которые не стесняются иллюстрировать забавными смайликами совсем не веселые сообщения.

В руководстве Facebook считают иначе: 200 страниц в своде правил модерации посвящено именно анализу эмодзи. Модераторам рекомендуется обращать особое внимание не только на смайлики с изображениями ножей, бомб, кулаков и пистолетов, но и на смеющиеся эмодзи – в большом количестве они могут быть признаками буллинга и высмеивания.

А эмодзи с изображением животного (например, крысы, свиньи или собаки) в контексте обсуждения какой-либо национальности может быть признано "дегуманизирующим сравнением". Ну а такие эмодзи, как банан, баклажан, клубника и язык считаются "намеками на секс", которые с недавних пор запрещены на Facebook и в текстовой форме.

Чистильщики

Марк Цукерберг регулярно обещает, что в скором будущем распознавание и удаление нежелательного контента будет происходить автоматически, с помощью искусственного интеллекта. Сейчас же реальность куда прозаичнее: решения принимают живые люди, в большинстве своем – бывшие сотрудники колл-центров из Филиппин и Марокко. На 2 миллиарда пользователей социальной сети со всего мира приходится около 15 000 таких "чистильщиков", и совсем недавно их было в два раза меньше.

Такие невинные, на первый взгляд, элементы, как эмодзи, могут обладать множеством негативных подтекстов – The New York Times

Представьте, что вам нужно быстро проверить на соответствие нормам Facebook публикацию политического активиста из Шри-Ланки, написанную на сингальском языке. Скорее всего, сначала придется загрузить текст в Google Translate, чтобы понять смысл хотя бы в общих чертах, а затем проверить значение отдельных слов и выражений, которые кажутся подозрительными. Для понимания контекста не помешает найти новости о последних событиях в стране, а для принятия окончательного решения – перечитать правила Facebook. А теперь представьте, что на всю операцию у вас есть примерно 5-10 секунд. Именно в таком режиме работают модераторы Facebook – компании, которая зарабатывает около $5 миллиардов в квартал.

На 2 миллиарда пользователей у Facebook порядка 15 тысяч модераторов, а до недавнего времени их было вдвое меньше

Ситуация осложняется тем, что вместо понятного алгоритма действий Facebook предоставил модераторам набор противоречивых рекомендаций в виде слайдов Power Point и Excel-таблиц – всего около 1400 страниц.

Неудивительно, что наряду со вполне объяснимыми проявлениями цензуры (например, удалением из канадской группы "желтых жилетов" комментариев, призывающих к убийству премьер-министра Джастина Трюдо, а также блокировкой аккаунта сына премьер-министра Израиля, назвавшего палестинцев "монстрами в человеческом обличье") соцсеть периодически веселит пользователей абсурдными решениями. Так, летом ее умельцы удалили отрывок из американской Декларации о независимости за нелестные слова в адрес коренных народов, сотрудничавших с британской короной.

Сложившееся положение некоторых сотрудников не устраивает – именно от одного из них американское издание получило материалы с правилами модерации. Тем временем высокопоставленные представители компании защищают свое право на ошибку, ссылаясь на цифры. В настоящее время на Facebook 2,27 миллиарда активных пользователей. Каждую минуту в соцсети появляется 510 000 новых комментариев, 293 000 публикаций и 136 000 фотографий. По словам Моники Бикерт, главы управления глобальной политики Facebook, даже если бы точность модерации составляла 99%, оставшийся 1% промахов при таких масштабах все равно был бы заметен.

Трудности перевода

Хотя Facebook заявляет, что главная цель модерации – защита пользователей, внутренние документы доказывают, что компания в первую очередь старается не поссориться с правительствами отдельных стран. При этом порой соцсеть вводит по собственной инициативе даже более суровую цензуру, чем того требует местное законодательство. Например, в Индии модераторам приказано удалять публикации с любыми негативными высказываниями о религии. По словам местных юристов, это явный перебор – в стране запрещено только "богохульство" с призывом к насилию против верующих, но не критика религии в целом. Также соцсеть по собственной инициативе внесла в черный список лозунг "Свободу Кашмиру", хотя индийские законы его вполне допускают.

Чтобы не поссориться с правительствами некоторых стран, Facebook может вводить даже более строгую цензуру, чем того требует местное законодательство

С другой стороны, некоторые ошибки приводят к тому, что откровенно экстремистский контент, несмотря на многочисленные жалобы, годами остается на платформе. "Бывает такое чувство, что наше бездействие убивает", – признается один из модераторов.

И это не метафора: например, из-за ошибки в правилах Facebook не удалял публикации буддистов-ультранационалистов из Мьянмы, призывающих к насилию против рохинджа и других религиозно-этнических меньшинств, но при этом блокировал аккаунты и группы активистов рохинджа. ООН полагает, что косвенно это привело к эскалации насилия и геноциду.

Правозащитники обеспокоены тем, что Facebook, по сути, формирует политические взгляды своих пользователей, даже если они не подозревают об этом. И речь не только о президентских выборах в США и "Брексите" в Великобритании. Например, накануне выборов в Пакистане модераторы получили 40-страничную методичку об основных политических силах с явно выраженными симпатиями и антипатиями.

А в июне 2018 года, когда власти Афганистана инициировали прекращение огня в конфликте с талибами, Facebook разрешил модераторам временно пропускать публикации сторонников Талибана при условии, если они поддерживают прекращение огня. Ранее все "положительные" сообщения о талибах блокировались. Также Facebook удаляет любые посты о тысячах тамильских повстанцев, убитых во время гражданской войны в Шри-Ланке.

Представители соцсети официально подтвердили подлинность соответствующих документов, хотя и заявили, что некоторые из них уже обновлены. Действительно, по словам источника издания, каждый вторник сотрудники компании собираются на утреннюю планерку, чтобы откорректировать правила. Но без системного подхода каждая правка только добавляет путаницы.

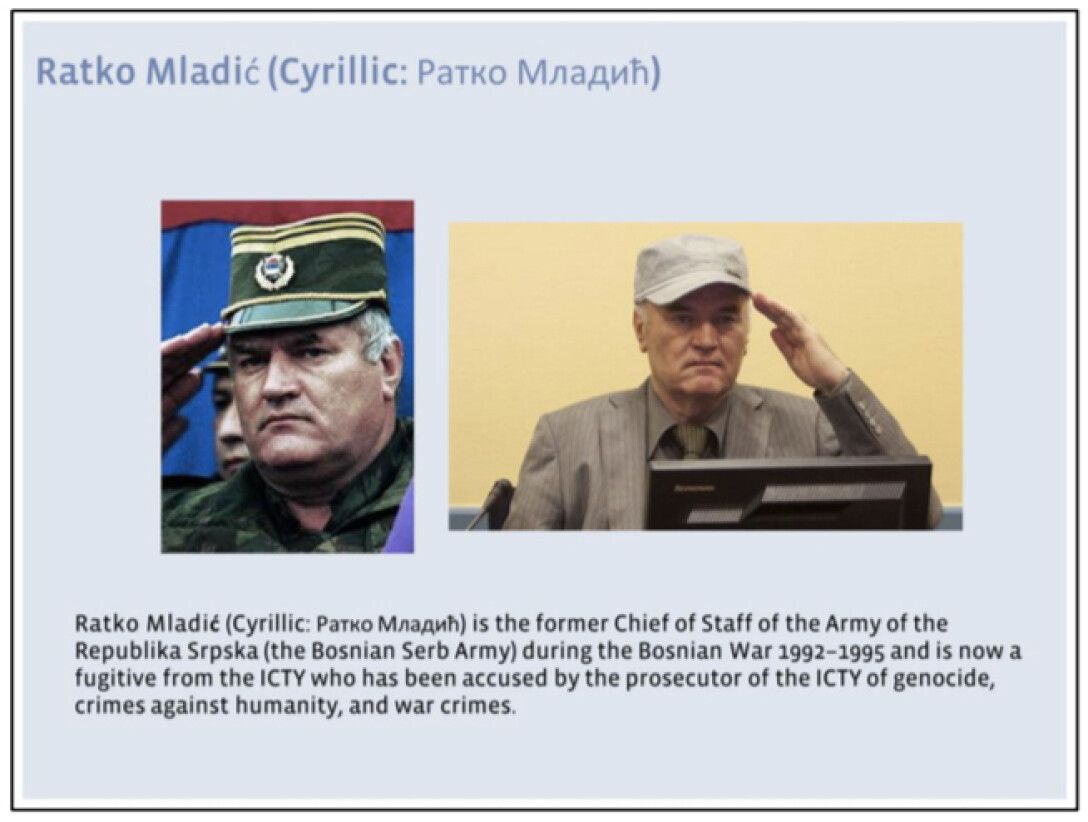

Качество модерации страдает и от банальной невнимательности составителей правил. Например, в пунктах, касающихся ситуации на Балканах, модераторам советуют тщательно проверять контент о военном преступнике Ратко Младиче, который якобы находится в бегах. На самом деле он был арестован в 2011 году. Журналисты заметили еще одну комичную деталь: на одном из слайдов речь идет о неком экстремисте по имени Rodney Young – это все тот же Младич, просто его имя пострадало от перевода через Google Translate.

Ратко Младич был арестован, но в своде правил модерации Facebook числился беглецом – The New York Times

Вообще, как оказалось, многие недоразумения с банами на Facebook объясняются именно языковым барьером. Большинство "чистильщиков" знают только свой родной язык и английский, тогда как им приходится проверять публикации на сотне языков. Один из нанятых соцсетью колл-центров на местном уровне принял простое решение: игнорировать все посты на незнакомых языках. И это обнажает еще одну гигантскую проблему: отдавая модерацию контента на аутсорс сторонним компаниям, Facebook не позаботился не только о составлении внятных правил, но и о контроле за их исполнением.

Эксперт по балканскому региону Ясмаин Муянович поделился с NYT мнением, что Facebook обладает столь большим влиянием на общественные дискуссии и политику, каким не должна обладать ни одна структура, тем более коммерческая. А теперь учтите, что один из важных инструментов этого влияния находится в руках малочисленного и низкоквалифицированного персонала, который работает в сжатые сроки и полагается на запутанные, а то и вовсе ошибочные рекомендации, сводящие к простейшим общим знаменателям сложные вопросы, нуждающиеся в многостороннем рассмотрении.